![[논문 리뷰]PERL(PE-RLHF); Parameter Efficient Reinforcement Learning from Human Feedback](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdna%2FdwwE0B%2FbtsMBgAYbUj%2FAAAAAAAAAAAAAAAAAAAAAHVe8kUMEXljEERBK6aJQXo2-wUIaCQHWlyjxevYMBUp%2Fimg.png%3Fcredential%3DyqXZFxpELC7KVnFOS48ylbz2pIh7yKj8%26expires%3D1772290799%26allow_ip%3D%26allow_referer%3D%26signature%3DG1o7SZWFIPh4vkNNTpUi1FZUSGc%253D)

최근 RLHF논문을 읽고, LLM Post-training 키워드를 전반적으로 정리했다.

그러다 LoRA와 같은 Parameter Efficient Fine Tuning과 Preference Tuning이 목적성은 다르지만 출력을 개선하기 위해 파라미터를 업데이트 한다는 관점에서 보면 같은 방향성을 가진다고 생각했고, RLHF에 Adapter의 개념을 결합하면 효율적인 Preference Tuning이 되지 않을까? 하는 생각이 들었다. 서치 결과 Parameter Efficient Reinforcement Learning from Human Feedback; PE-RLHF라는 관련 논문이 2024년 9월에 프리프린트되어 있어 해당 논문을 리뷰한다.

Abstract

해당 논문은 LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS(Hu et al. (2021))논문에서 소개된 LoRA라는 PEFT 방법론을 활용하여 모델을 학습하는 RLHF 방식을 소개한다. 성능확인을 위해 reward modeling과 reinforcement learning에 관한 2개의 새로운 데이터셋과 7개의 벤치마크로 기존의 RLHF(full fine-tuning)방법론과 비교한다. 연구 결과 PE-RLHF는 기존의 전통적인 RLHF 설정과 동등한 성능을 보이면서도 학습 속도가 빠르고 메모리 사용량이 적은 결과를 보인다.

추가로 이 논문에서는 RLHF 관련 연구를 위한 2지선다 선호도 데이터셋인 ‘Taskmaster Coffee’와 ‘Taskmaster Ticketing’을 공개한다.

Introduction

aligning을 달성하기 위한 RLHF에서 가장 큰 걸림돌은 그 과정에서의 복잡성과 계산 비용이다. 예를 들어, RL 루프는 보상 모델과 KL 정규화를 위한 앵커 모델(RLHF 과정에서 정책 업데이트가 지나치게 원래 모델의 특성과 멀어지지 않도록 제어하는 reference 모델) 등 여러 LLM 인스턴스가 필요하기 때문에 표준 파인튜닝보다 최소 두 배의 메모리가 요구된다. 또한 효과적인 RM모델을 생성하기 위해 대량의 고품질 데이터를 수집하는 것도 RLHF의 단점으로 작용한다.

본 연구에서는 파라미터 효율적 미세조정(PEFT) 접근법 (Houlsby et al., 2019)이 RLHF를 보다 효율적이고 접근하기 쉽게 만들기 위해 RLHF와 PEFT방법론 중 하나인 LoRA를 활용하는 PE-RLHF 방법론을 소개한다. 또한 Abstract에서 설명한 내용과 추가로 RM과 RL 정책의 학습에 있어 LoRA가 모델 크기와 학습 가능한 LoRA 파라미터 수라는 두 차원에 미치는 영향을 평가한다.

RM 모델 학습에서 PE-RLHF는 표준 RM모델 학습에 비해 43-74%의 HBM(최대 메모리 사용량)을 사용하며, 1.4-1.9배 빠른 학습 속도를 보이는 반면, 보상 모델 정확도 측면에서는 표준 RM 훈련과 맞먹는 결과를 보여준다.

RL 과정에서 PE-RLHF는 표준 RLHF와 맞먹는 결과를 내면서도 피크 시 73-80%의 HBM을 사용하며, 1.15-1.3배 빠른 학습 속도를 보인다.

Parameter Efficient Reinforcement Learning from Human Feedback

이 논문에서는 기존의 RLHF 3단계(SFT-RM-RL) 중 RM 훈련과 RL에서 PEFT 기법을 적용하여 메모리 요구량을 줄이고 학습속도를 향상시킨다. SFT 단계에서는 모델의 기초적인 성능을 확보하기 위해 Full fine-tuning을 진행하는 것으로 보인다.

Reward Model Training

훈련 시, 위 그림과 같이 언어 모델의 백본은 고정된 상태로 유지되며 오직 LoRA 어댑터만 학습된다. 추론 단계에서는, 학습된 LoRA 어댑터는 덧셈 연산을 통해 결합되어, 기능적으로 non-LoRA 모델과 동일한 보상 모델을 생성한다.

Reinforcement Learning of Policy

강화학습 단계에서도 LoRA어댑터를 학습(Policy update)하여 연산량을 줄인다.

Datasets and tasks

이 PE-RLHF 연구에서는 아래의 Task들을 진행한다.

- 긴 텍스트를 간결하게 요약하는 텍스트 요약 Task (예: Reddit TL;DR, BOLT Message Summarization)

- 해로운 출력을 억제하기 위해 덜 해로운 응답에 대한 선호도를 기반으로 보상 모델을 학습하는 Harmless Response Generation Task

- 도움(helpfulness)에 초점을 맞춘 유용한 응답 생성 Task (Stanford Human Preference 데이터셋 기반)

- UI 자동화를 통한 기기 제어 Task (AndroidControl 데이터셋 기반)

- 시각 정보를 이해하고 질문에 답하는 Visual Question Answering Task (VQAv2 데이터셋 기반)

Experimental Setup and Metrics

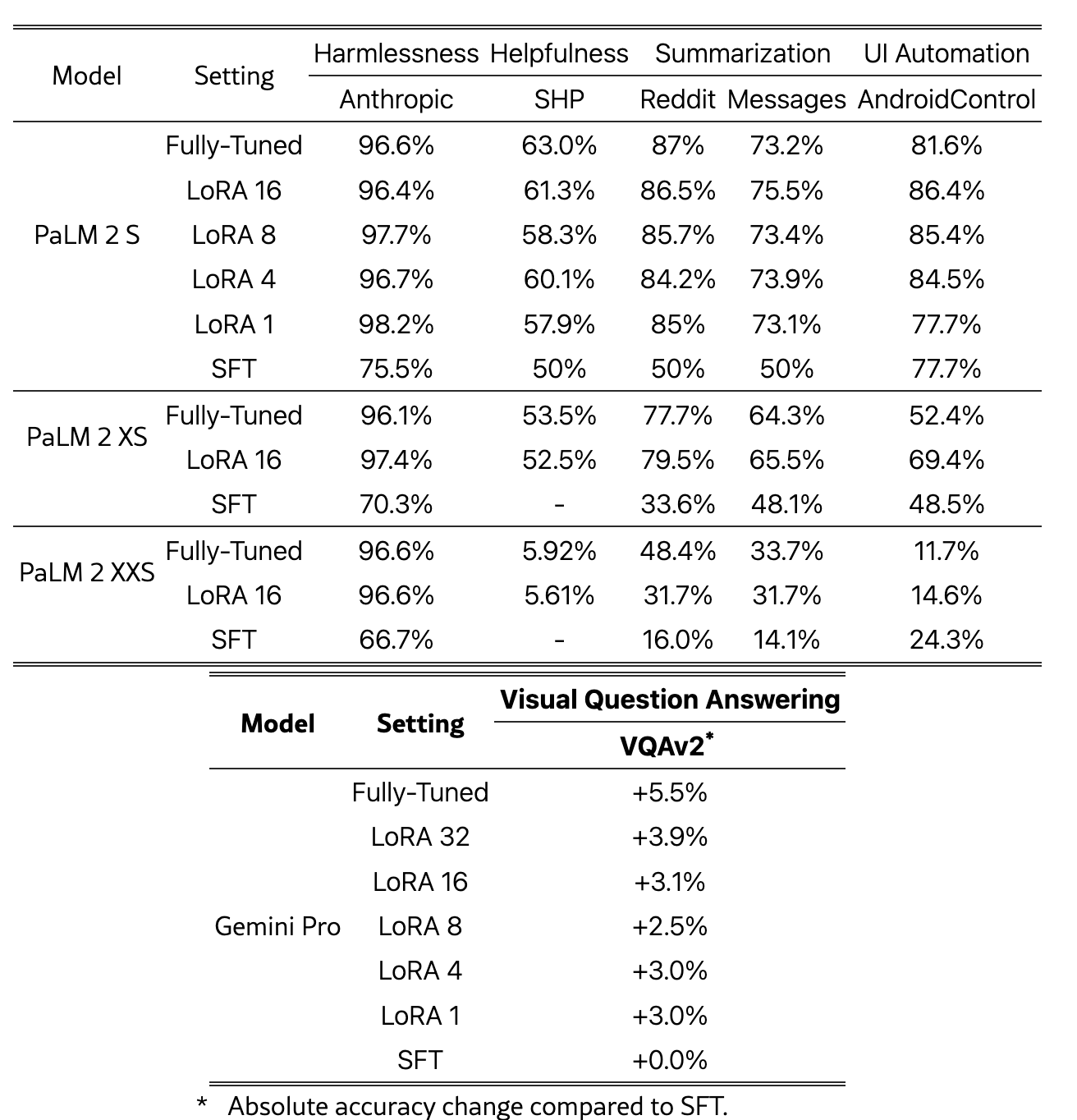

이 연구에서는 PaLM2와 Gemini Pro 두개의 모델로 6개 데이터셋에서의 PE-RLHF 성능을 평가한다.

Reward Modeling

LoRA 어댑터를 활용하여 사전학습된 언어 모델의 백본은 고정한 채 RM을 학습한다.

선호 기반 평가에서는 pairwise-accuracy를, 분류 방식에서는 정확도를 측정하며, Jax JIT로 추정한 HBM 사용량의 피크 값과 학습 속도도 함께 평가한다.

Reinforcement Learning

“REINFORCE for Language Models” 알고리즘을 이용해 정책과 가치 모델을 학습하며, 고정된 보상 모델을 사용하여 비교한다. 이 과정 역시 LoRA 어댑터를 사용한다.

Evaluations

PaLM 2 L 모델을 판정모델로 사용해 아래의 기준에 따라 평가한다.

- 텍스트 요약: 기준 응답과 정책 응답 쌍에서 선호하는 응답을 선택하도록 요청한다. 판정자 모델은 위치 편향(positional bias; 응답의 제시순서가 결과에 영향을 미치는 것)을 제거하기 위해 두 가지 순서로 판정을 받아, 두 번 모두 선호된 경우에만 승리(win)로 간주하며, 한 순서에서만 선호되면 이를 무승부(tie)로 분류한다. 이를 통해 정책의 승률을 측정한다.

- 해로운 응답 생성: 생성된 응답이 해롭지 않은지 YES/NO 방식으로 평가하여, harmful rate(해롭지 않은 응답의 비율)를 산출한다.

- 유용한 응답 생성: 텍스트 요약과 유사하게, 기준 응답과 정책 응답 쌍에서 더 유용한 응답을 선택하도록 요청하여 승률을 측정한다.

- 비주얼 질문 응답: 강화학습 정책의 정확도와 Supervised Fine-Tuned Gemini 정책의 정확도 차이로 평가한다.

- UI 자동화: 작업 설명과 함께 정책 모델이 생성한 행동을 제시하고, 그 행동이 올바른지 판정하여 정확도(정확한 행동의 비율)를 산출한다.

Results and Takeaways

Performance of PE-RLHF

PE-RLHF가 보상 모델링과 강화학습 모두에서 기존의 RLHF와 동등한 결과를 달성했다. 텍스트 기반 작업에서 모델 파라미터의 0.1% 미만, 시각과 텍스트가 모두 포함된 작업에서는 0.2% 미만의 파라미터만 학습하여 달성한 결과이다.

사람의 피드백을 수집하여 판정모델로서의 PaLM 2 L 모델의 품질을 평가했고, Human feedback-PaLM 2 L 간의 일치를 계산하여 판정모델의 타당성 역시 검증하였다.

Effects of Model Size and LoRA Rank

reward 모델과 강화학습 정책의 성능에 대한 모델 크기와 LoRA rank의 영향을 테스트하기 위해 ablation 연구를 수행했다.

LoRA rank를 변화시켜도 보상 모델의 성능에는 큰 차이가 없는 것으로 관찰되었다. 그러나 모델 백본의 크기가 커질수록 reward modeling 효과가 더 좋아지며, Fully tuned에 더 근접한 성능을 보인다. 가장 작은 모델에서는 PE-RLHF와 Fully-tuned모델간의 성능차이가 보이지만, 큰 모델에서는 동일한 수준의 성능을 보인다.

PE-RLHF reward 모델은 Fully tuned된 reward 모델의 정확도와 일치하며, 백본 모델의 크기가 증가할수록 Fully tuned된 reward 모델과 동일한 성능을 내는 효과가 더욱 두드러진다. 또한, LoRA rank의 변화에 따라 성능의 유의미한 차이는 관찰되지 않는다.

반면, 강화학습 실험에서는 LoRA rank가 증가할수록 판정자 LLM에 의해 평가된 PE-RLHF 정책의 성능이 더 좋아지는 것이 관찰된다. 큰 모델 백본일수록 PE-RLHF 정책의 결과가 표준 RLHF 정책보다 더 우수하며, 이는 보상 모델에서 관찰된 추세와 일치한다. 가장 작은 모델 크기에서는 PE-RLHF가 완전 파인튜닝된 강화학습 정책보다 약간 낮은 성능을 보이지만, 가장 큰 크기에서는 두 방법이 동일한 성능을 보인다.

PE-RLHF 정책은 표준 RL 정책과 동일한 성능을 보이며, LM의 크기가 커질수록 더 효과적이다. LoRA rank에 따른 성능 변화는 크게 관찰되지 않았다.

Memory and Speed Advantages of PE-RLHF

Adam (Kingma and Ba, 2017) 및 Adafactor (Shazeer and Stern, 2018)와 같은 최신 옵티마이저는 각 학습 가능한 파라미터에 대해 여러 요소를 추적하기 위해 상당한 메모리를 필요로 한다. PE-RLHF는 학습해야 하는 파라미터 수를 크게 줄임으로써 보상 모델 학습과 정책의 강화학습 모두에서 메모리 사용량을 크게 낮춰 Fully tuned된 보상 모델과 동일한 성능을 달성하면서도 학습 시 필요한 최대 HBM의 43%에서 74%만 사용한다. 또한, PE-RLHF 강화학습은 표준 RLHF와 동일한 성능을 달성하면서도 최대 HBM의 74%에서 80%만 사용한다.

이는 학습속도의 향상으로 이어지며, PE-RLHF reward 모델은 표준 보상 모델보다 1.15배에서 1.9배 빠른 학습 속도를 보이며, PE-RLHF 강화학습은 표준 RLHF의 RL 루프보다 1.15배에서 1.24배 빠른 속도를 보인다.

또한, 학습 가능한 파라미터 수의 변화가 전체 파라미터 대비 매우 작기 때문에(최대 LoRA rank 32에서도 <1%), 메모리 절감 효과와 속도 향상은 LoRA rank에 따라 크게 달라지지 않는다.

Conclusion and Future Work

본 연구는 LoRA를 적용한 PE-RLHF 방식이 표준 RLHF와 유사한 성능을 내면서도 메모리 사용량과 학습 시간을 크게 줄일 수 있음을 보여줬다. 하지만, 파라미터 효율 미세조정 방식은 과적합과 보상 해킹 문제에 취약할 수 있으므로, 향후 연구에서는 아래의 세 가지 방향에 주목할 필요가 있다.

- 일반화 강화: 앙상블 기법(Mixture-of-LoRA)을 활용해 도메인 간 견고성을 높이는 방법

- 보상 해킹 완화: 가중치 평균화 기법을 도입해 보상 해킹 문제를 줄이는 접근

- 오픈 소싱: 오픈 소스 모델을 활용한 PE-RLHF와 표준 RLHF 비교 사례 공개

Limitations

PE-RLHF는 효율성과 성능 면에서 유망하지만, 다음과 같은 한계점이 있다.

- 잠재적 과적합: 파라미터 효율 미세조정 방식 특성상 훈련 데이터에 과적합될 위험이 있으며, 이를 해결하기 위한 정규화 및 완화 전략이 필요하다.

- 데이터 효율성: RLHF의 계산 부담은 줄었지만, 최적의 데이터 요구량에 대해서는 여전히 불확실하므로, 데이터 효율성을 개선하는 연구가 중요하다.

- 다른 방법과의 비교: 본 연구는 LoRA에만 집중했으며, DoRA 등 다른 최신 PEFT 및 ReFT 기법이 RLHF 설정에서 어떻게 작동하는지 추가로 탐구할 필요가 있다.

Ethics Statement

PE-RLHF 방식은 효율적인 정렬(alignment)을 가능하게 하지만, 비용 절감이라는 이점이 있는만큼 유해한 방향으로도(허위정보나 혐오발언) LLM을 쉽게 훈련시킬 가능성이라는 윤리적 문제점이 있다. 이를 방지하기 위한 LLM 개발 및 배포에 관한 윤리적 가이드라인의 수립이 필요하다.

'Insights > Language Model' 카테고리의 다른 글

개발새발라이프

hi there🙌

![[논문리뷰] RLHF;Training language models to follow instructions with human feedback](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdna%2FcS0gf1%2FbtsMuwjO26o%2FAAAAAAAAAAAAAAAAAAAAAOQH6nKcwHNaT-mF8St2ZF3Bz5bVJCQsZIopzRxiH1gr%2Fimg.png%3Fcredential%3DyqXZFxpELC7KVnFOS48ylbz2pIh7yKj8%26expires%3D1772290799%26allow_ip%3D%26allow_referer%3D%26signature%3DQbiPDNyYGT0u4%252FnZ2Uk6l7HA4xE%253D)